개요

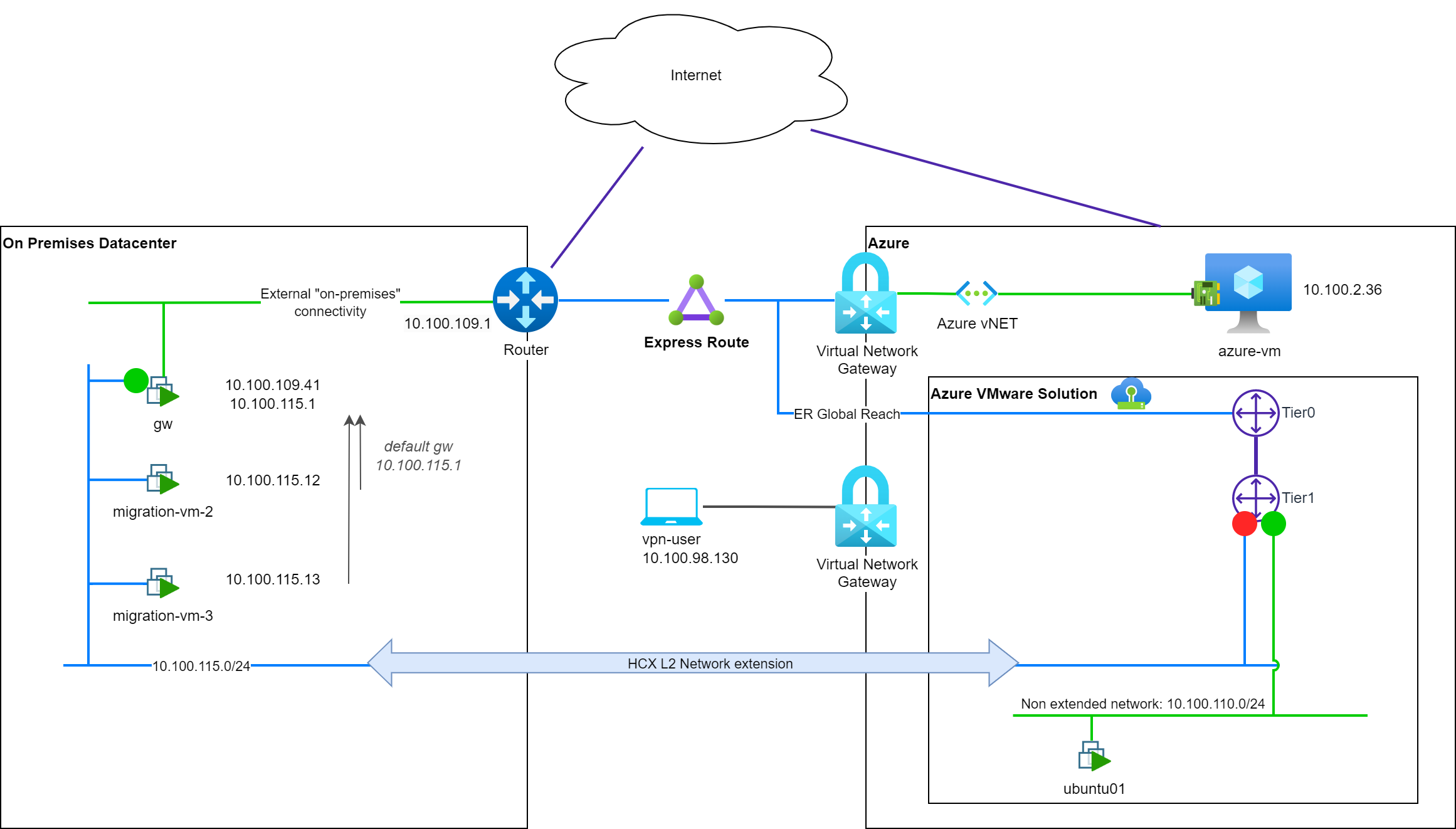

이전 블로그 게시물 시리즈(게시글: 1 , 2 , 3 )에서는 Azure에 타사 방화벽 네트워크 가상 어플라이언스(NVA)를 구축하여 허브앤스포크 네트워크 토폴로지에 Azure VMware 솔루션(AVS) 배포를 통합하는 방법을 다루었습니다. 이 설정은 AVS 환경(N/S )에서 송수신 되는 트래픽 에 대한 트래픽 필터링을 지원하지만 , AVS 워크로드(E/W) 간에는 필터링 기능을 제공하지 않습니다. 이를 위해 권장되는 방법은 NSX-T 분산 방화벽 기능을 활용하는 것입니다.

이 블로그 게시물에서는 NSX-T 분산 방화벽 기능에 의존하지 않고 AVS 워크로드 간 트래픽 필터링을 제공하기 위해 AVS SDDC 자체에 타사 방화벽 NVA를 배포하는 방법을 다룹니다.

AVS SDDC에 3 차 방화벽 NVA를 구축하는 이유에 대해서는 여기서 설명하지 않겠습니다 . 다만, 온프레미스 데이터센터에서 사용해 온 것과 동일한 방화벽 기술을 AVS에서도 계속 사용하고자 하는 고객들의 일반적인 요청이라는 점만 말씀드리겠습니다.

이 주제는 이전 블로그 게시물에서도 몇몇 동료가 다루었습니다.

- Amit Aneja (Microsoft) 가 만든 Azure VMware 솔루션의 타사 방화벽 NVA .

- Kenyon Hensler (Microsoft) 가 제시한 AVS의 타사 방화벽 .

- Azure VMware 솔루션: 타사 네트워킹 및 보안 플랫폼 연결 작성자: Gourav Bhardwaj (VMware), Trevor Davis (Microsoft), Jeffrey Moore (VMware).

이러한 솔루션을 배포하는 데 도움이 되는 몇 가지 세부 정보를 제공하려고 노력하겠습니다.

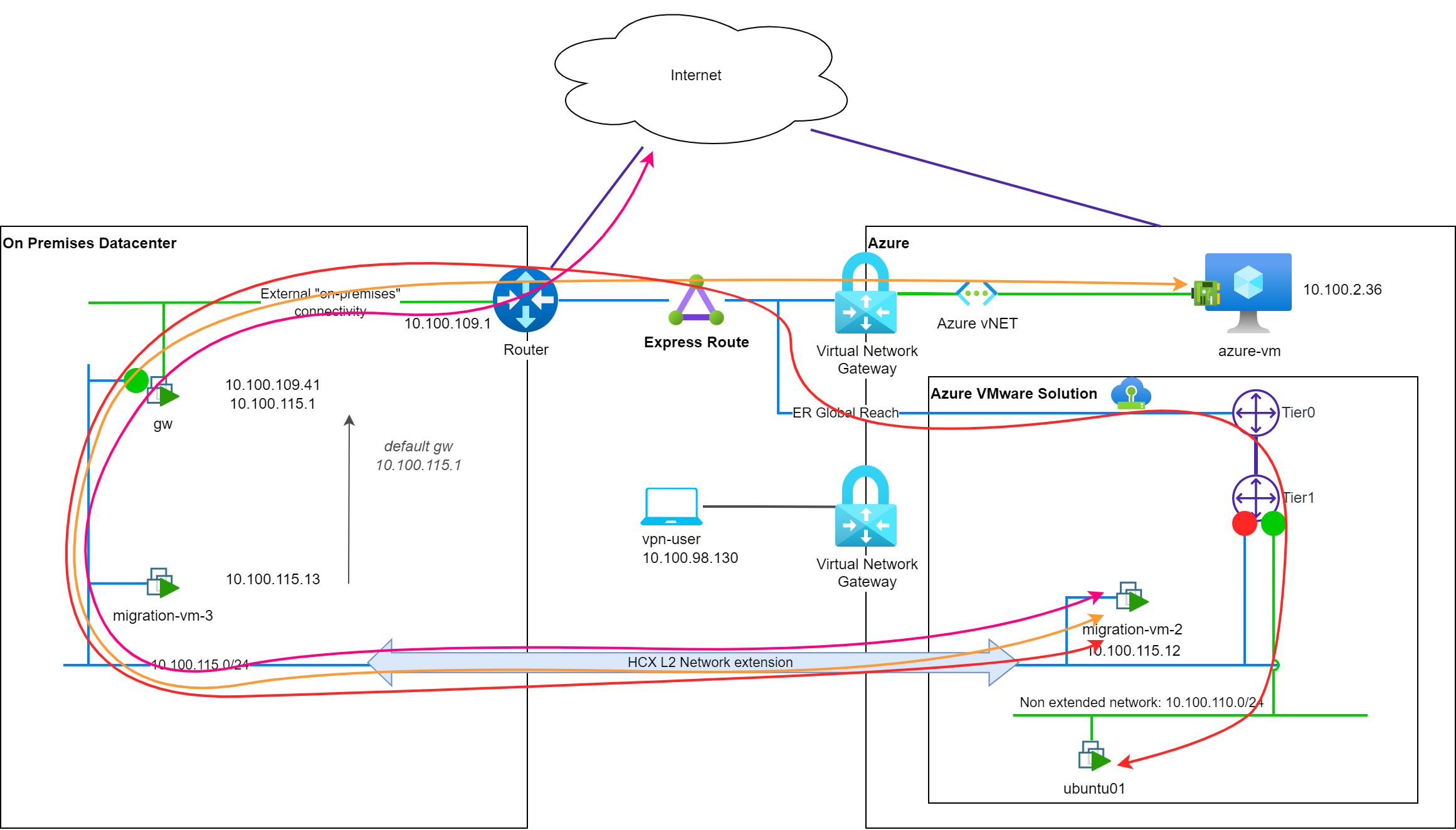

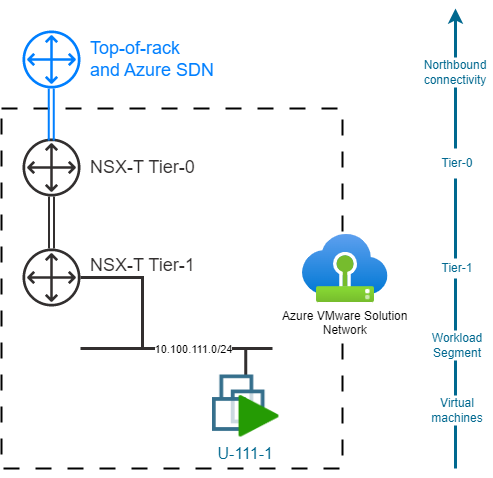

기본 AVS 토폴로지

기본적으로 AVS SDDC는 사전 프로비저닝된 NSX-T Tier-0 및 Tier-1 게이트웨이와 함께 배포됩니다. Tier-0 게이트웨이는 AVS SDDC를 ToR(Top-of-Rack) 및 Azure SDN에 연결하는 데 사용되며, Microsoft에서 완벽하게 관리합니다. 기본 Tier-1 게이트웨이는 네트워크 세그먼트를 배포하는 데 사용할 수 있으며, 고객이 직접 관리합니다. 고객은 필요한 경우 Tier-1 게이트웨이를 추가로 생성할 수도 있습니다.

AVS SDDC에 타사 방화벽 NVA를 삽입하는 과제

AVS SDDC에 타사 NVA를 삽입할 때 고려해야 할 첫 번째 한계는 NSX -T 서비스 삽입 기능을 사용할 수 없다는 것입니다 . 이 한계는 주로 Azure VMware 솔루션의 " 관리형 " 특성 에서 비롯됩니다 .

고려해야 할 두 번째 한계는 AVS SDDC에 구축된 타사 NVA가 단일 VM에 연결할 수 있는 가상 네트워크 인터페이스 수에 의해 제한된다는 것입니다. 가상 머신당 사용 가능한 NIC가 10개뿐이므로 워크로드 세그먼트가 9개 이상인 배포 환경에 NVA를 직접 연결하는 것은 불가능합니다.

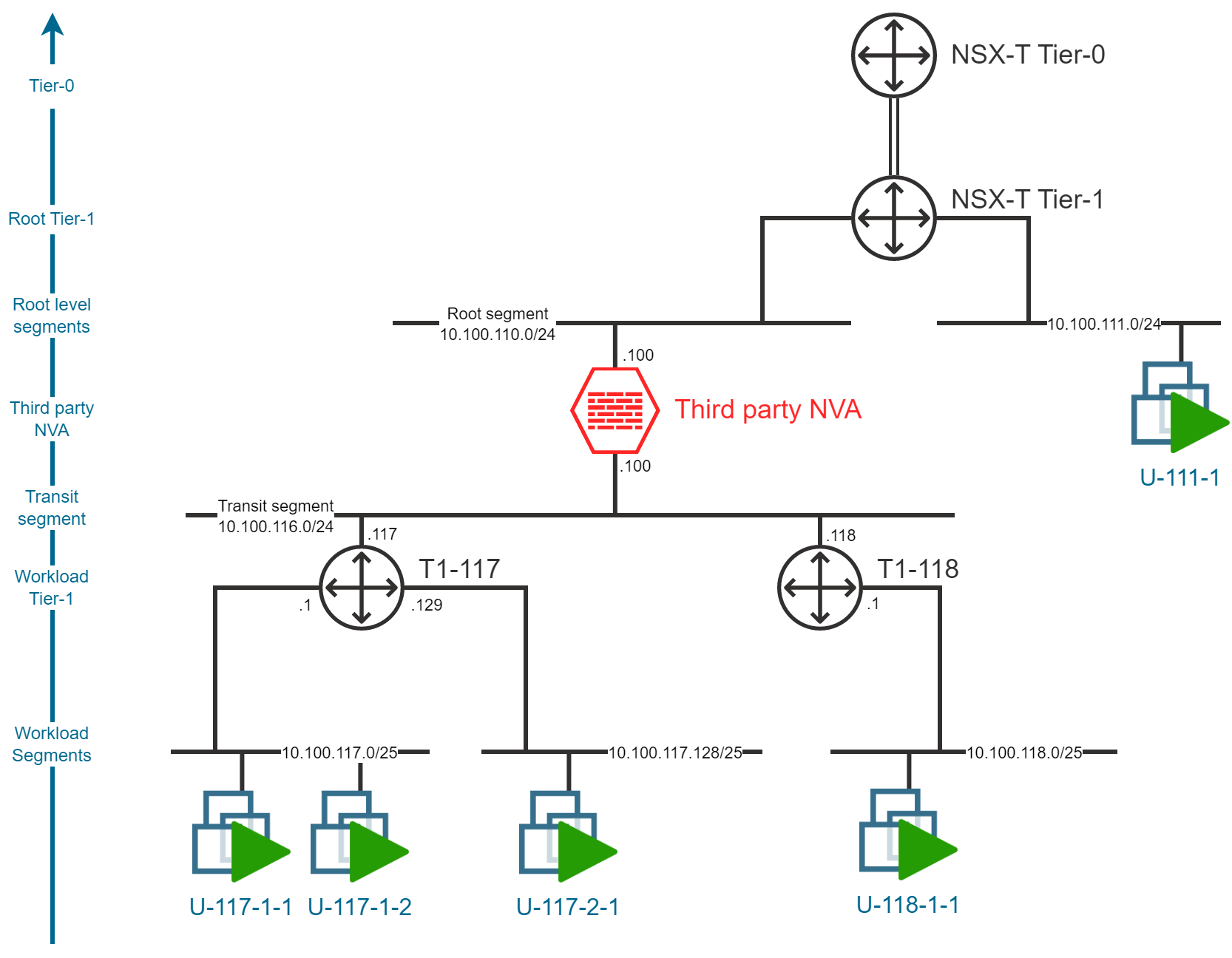

가능한 완화책은 트랜짓 세그먼트를 사용하는 것입니다 . 이 트랜짓 세그먼트는 추가 Tier-1 게이트웨이에 연결되며, 추가 Tier-1 게이트웨이를 통해 NVA와 워크로드 세그먼트 간의 트래픽을 라우팅하는 데 사용됩니다. 이 토폴로지에서 새로운 제한은 AVS SDDC에 배포할 수 있는 최대 Tier-1 게이트웨이 수 및/또는 트랜짓 서브넷 주소 계획의 크기를 기반으로 합니다. 이를 통해 필요한 경우 수백 개의 워크로드 세그먼트를 프로비저닝할 수 있습니다.

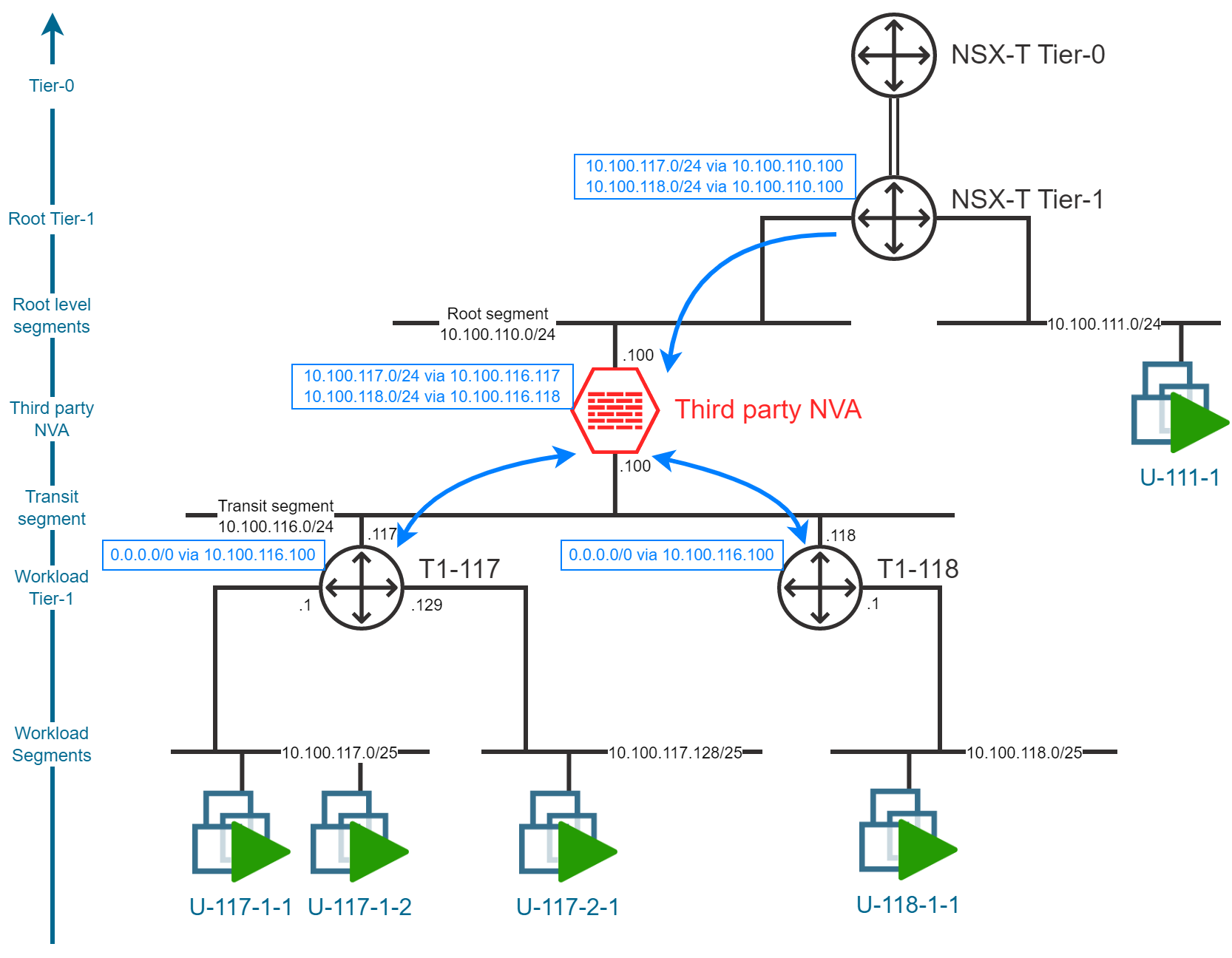

계층화된 네트워크 토폴로지

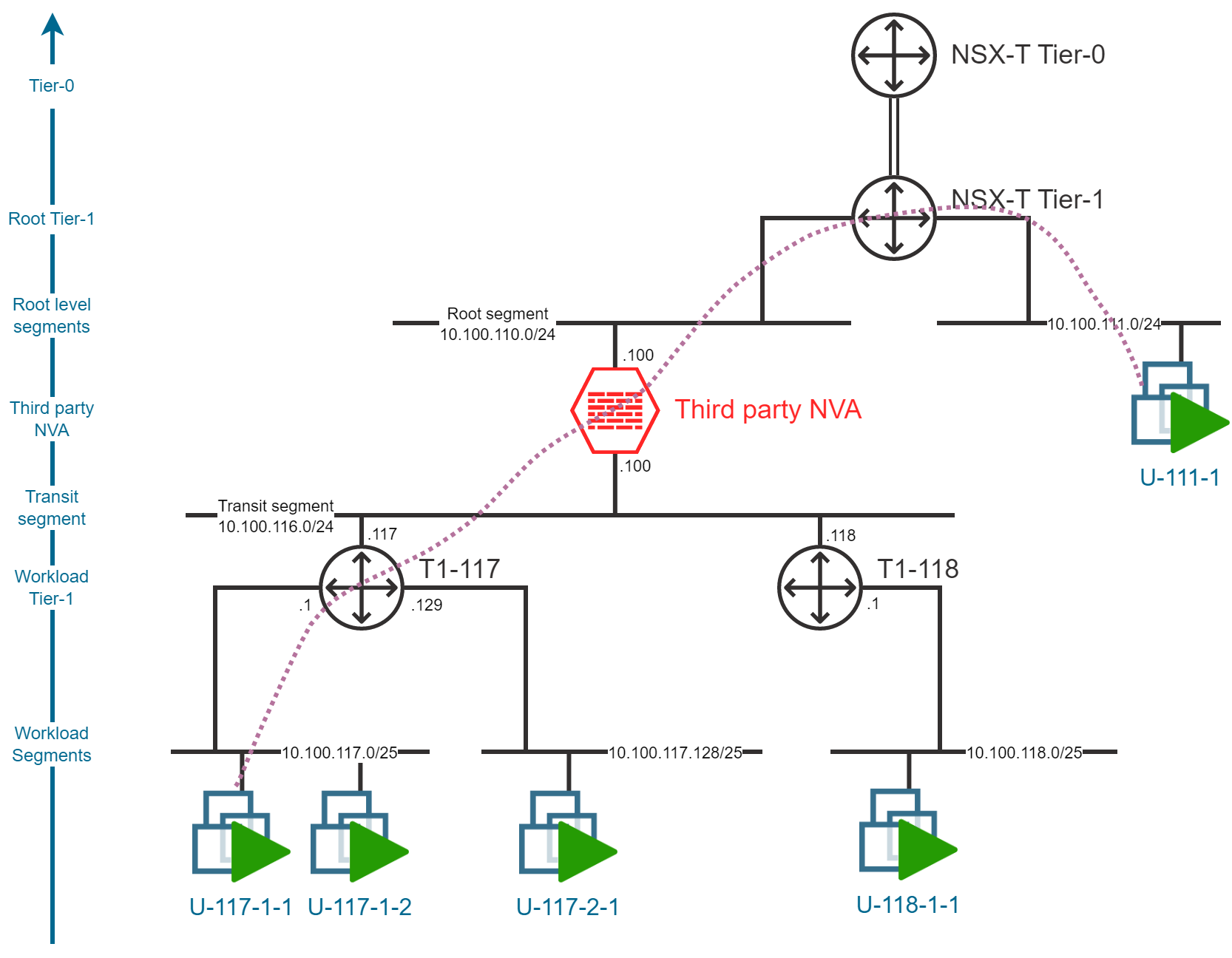

AVS SDDC에 타사 방화벽 NVA를 구축하려면 계층형 네트워크 토폴로지를 구축해야 합니다. 이 토폴로지는 3개의 계층으로 구성됩니다.

- Tier-1 게이트웨이의 첫 번째 계층(기본적으로 배포된 것과 같음)과 NVA 업링크에 연결된 루트 세그먼트입니다 .

- NVA 다운링크 및 Tier-1 게이트웨이의 두 번째 계층에 연결된 하나 이상의 Transit-segment

- 가상 머신이 배포될 워크로드 세그먼트입니다.

환승 구간 또는 환승 구간

배치할 Transit-segment 수와 관련하여 두 가지 가능한 전략이 있습니다 .

- 여러 개의 Transit-segment를 사용하면 최대 8개의 Tier-1 게이트웨이를 추가로 구축할 수 있습니다. 각 Tier-1 게이트웨이는 최대 1000개의 워크로드 세그먼트에 연결할 수 있습니다.

- 이러한 설정은 확장성을 제공 하지만 단일 Tier-1 게이트웨이에 연결된 세그먼트는 NVA를 통해 서로 통신하지 않습니다 .

- 이러한 설정은 유지 관리가 더 복잡할 수 있으며 NVA 수준에서 E/W 트래픽 필터링이 필요한 경우 확장성에 제한이 있습니다.

- 단일 Transit-segment를 사용하면 더 많은 Tier-1 게이트웨이(100개)를 배포하고 워크로드 세그먼트당 1개의 Tier-1 게이트웨이를 전용으로 지정할 수 있습니다 .

- "작업 부하 세그먼트당 1개의 Tier-1 게이트웨이" 설정은 E/W 트래픽 필터링과 관련하여 위에서 언급한 문제를 완화합니다.

- 이러한 설정은 보안 권장 사항 섹션 에서 언급한 것과 같은 보안 문제를 고려할 수도 있습니다 .

- 확장성은 전송 서브넷 크기 에 따라 제한됩니다 . IP 주소가 부족해지지 않도록 적절한 계획이 필요합니다.

참고 : 이 블로그 게시물에서는 두 가지 전략을 설명하려고 합니다.

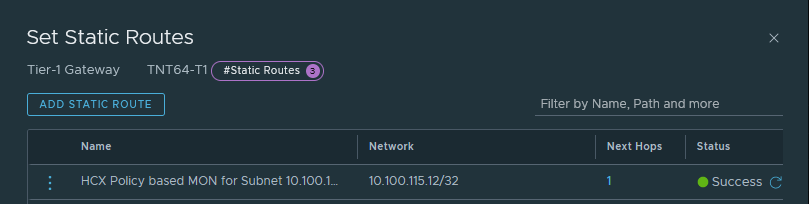

정적 경로

여러 세그먼트 간의 트래픽을 라우팅하려면 Tier-1 게이트웨이에 정적 경로를 구성해야 합니다. 다음 표는 Tier-1 게이트웨이에 구성해야 하는 정적 경로에 대한 개요를 제공합니다.

| 루트 티어-1 | 작업 세그먼트 | NVA |

| 워크로드 Tier-1 | 기본 경로(0/0) | NVA |

| NVA | 작업 세그먼트 | 워크로드 Tier-1 |

다음은 내 연구실 환경에 적용된 예입니다.

교통 흐름 분석

세그먼트 내 트래픽

이미 짐작하셨겠지만, 동일한 워크로드 세그먼트에 배포된 가상 머신의 트래픽 흐름은 NVA 삽입의 영향을 받지 않습니다. 트래픽은 L2 레벨에서 가상 머신 간에 직접 라우팅됩니다.

참고 : NSX-T 분산 방화벽 기능을 활용하면 동일 세그먼트에 있는 가상 머신 간 트래픽을 필터링할 수 있습니다 .

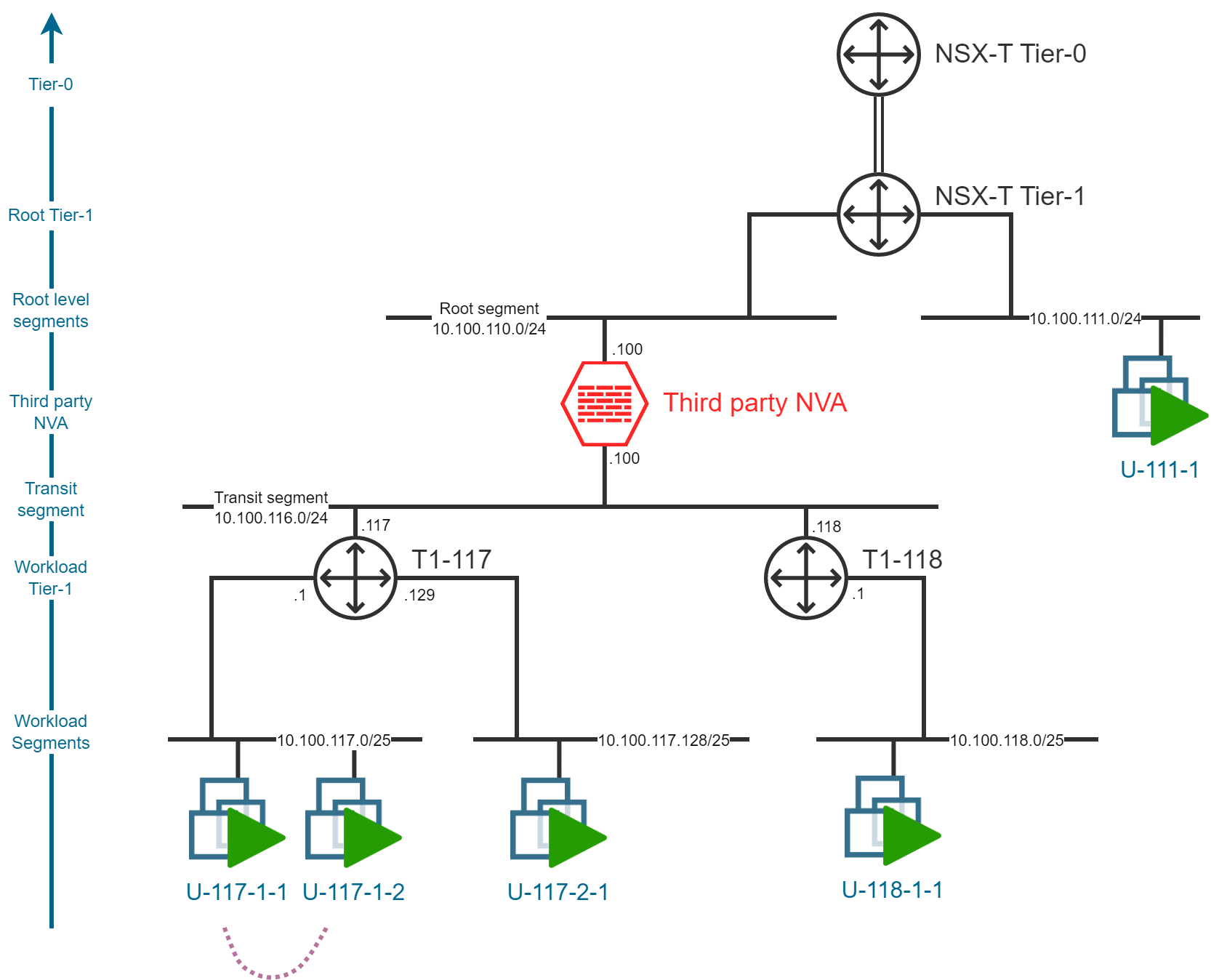

동서, 구간 간 교통량, 동일 Tier-1

동일한 Tier-1 게이트웨이에 연결된 서로 다른 워크로드 세그먼트에 배포된 가상 머신 간의 트래픽 흐름은 NVA 삽입의 영향을 받지 않으며 트래픽은 Tier-1 게이트웨이를 통해서만 전달됩니다.

이러한 종류의 네트워크 트래픽을 필터링하려면 NSX-T 분산 방화벽 이나 게이트웨이 방화벽 기능을 사용할 수 있습니다 .

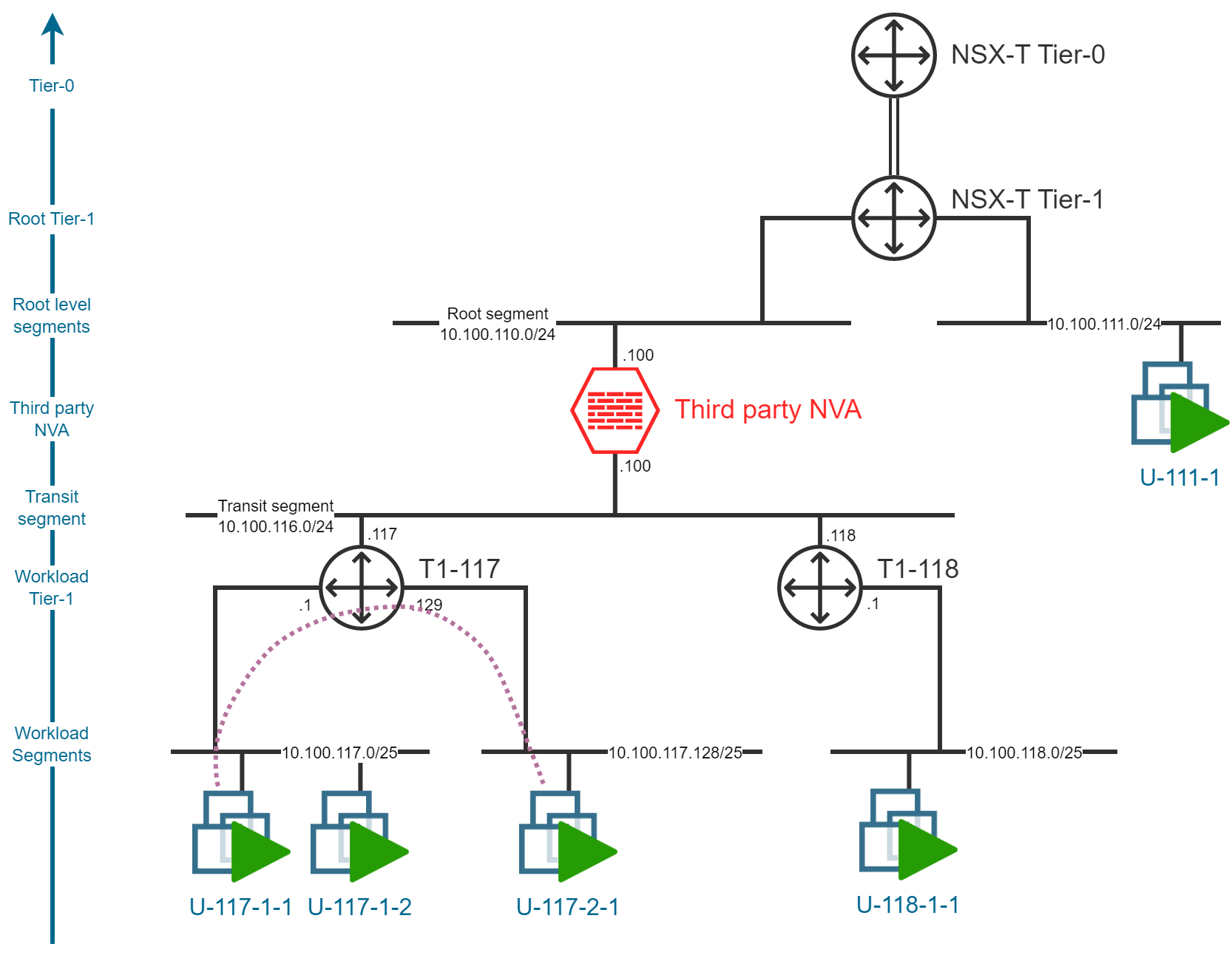

동서, 구간 간 교통, 다양한 Tier-1

서로 다른 Tier-1 게이트웨이에 연결된 여러 워크로드 세그먼트에 배포된 가상 머신 간의 트래픽 흐름은 NVA 삽입의 영향을 받습니다. 트래픽은 NVA와 Tier-1 게이트웨이를 통해 라우팅됩니다.

이는 NVA 삽입을 통해 달성하고자 하는 교통 흐름의 가장 대표적인 구성입니다.

이 구성을 일반화하려면 워크로드 세그먼트별로 Tier-1 게이트웨이를 배포해야 합니다 .

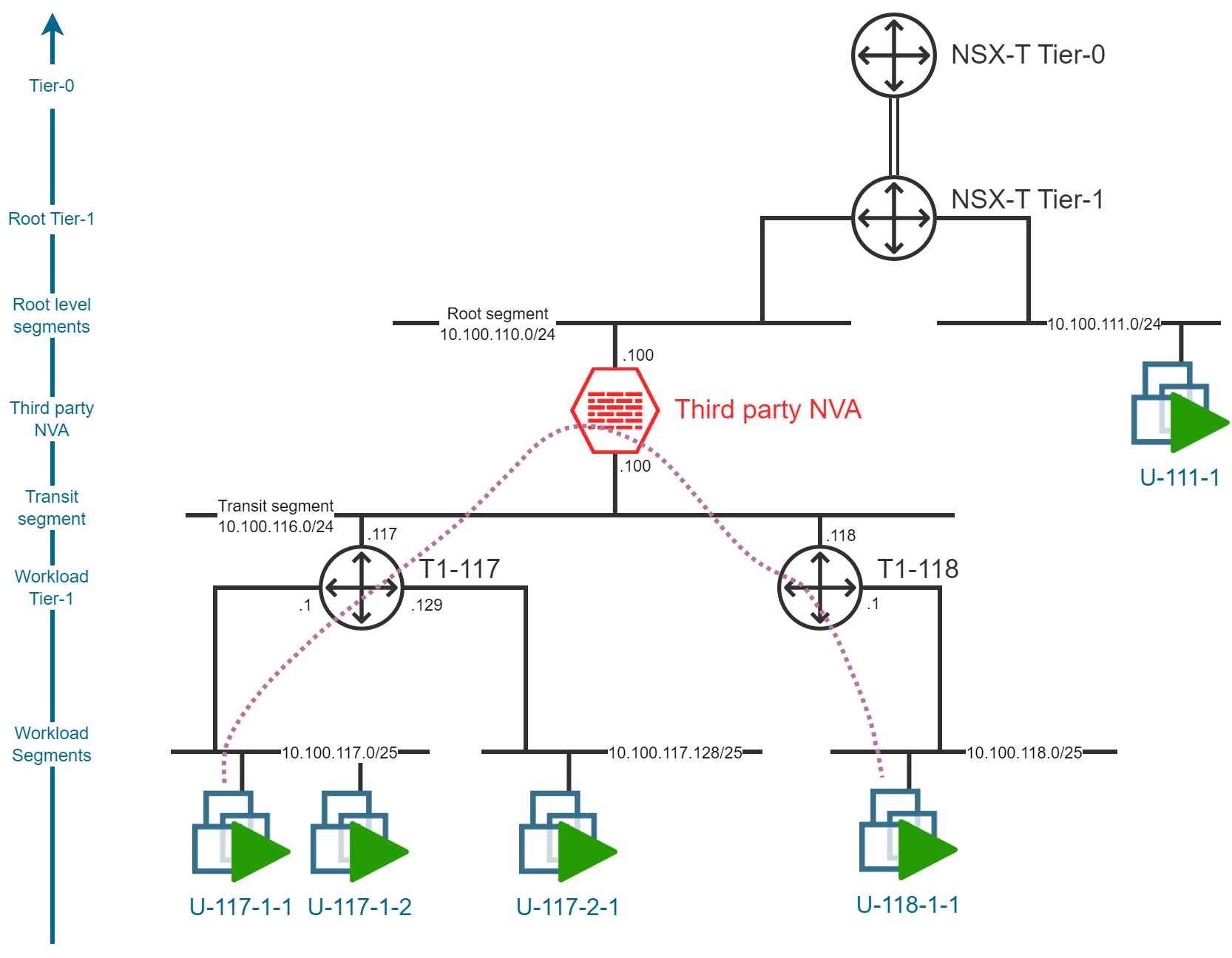

남북 교통

남북 트래픽도 NVA 삽입의 영향을 받습니다. 트래픽은 NVA를 통해 라우팅되어 NVA 북쪽에 있는 모든 대상에 도달합니다. 기본 Tier-0/Tier-1 게이트웨이의 남쪽에 직접 배포된 가상 머신 또는 다음과 같이 기본 Tier-0/Tier-1 게이트웨이를 통해 도달 가능한 다른 대상에 도달합니다.

- Azure 기반 리소스

- ExpressRoute 또는 VPN을 통한 온프레미스 리소스

- 인터넷

기타 고려 사항

보안 권장 사항

NVA 뒤에 여러 라우팅 장치(Tier-1 게이트웨이)가 배치되어 있는 경우, 트래픽이 NVA를 우회하지 않도록 하는 것이 중요합니다. 분산 방화벽 수준에서 ICMP 리디렉션을 차단하고 NVA를 다음과 같이 구성하는 것이 좋습니다.

- ICMP 리디렉션 무시

- ICMP 리디렉션을 보내지 않음

새로운 정적 경로를 도입하면 트래픽 라우팅이 NVA를 우회할 수도 있습니다. Tier-1 게이트웨이에서 정적 경로를 올바르게 구성하는 것이 중요합니다.

NVA 고가용성

여기서는 단일 NVA 인스턴스로 필터링되는 트래픽 흐름을 설계하고 구성하는 기능만 설명했습니다. 운영 환경에서는 NVA의 고가용성을 고려하는 것이 중요합니다. 여러 NVA 인스턴스를 배포하고 VRRP(Virtual Router Redundancy Protocol) 그룹화 및 로드 밸런싱을 통해 NVA의 고가용성을 확보할 수 있습니다.

알려진 제한 사항

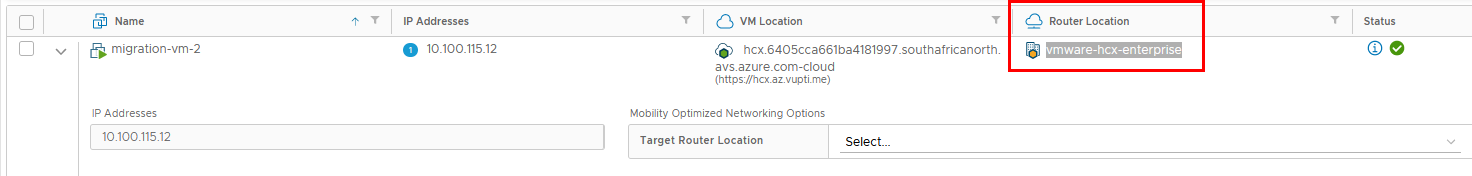

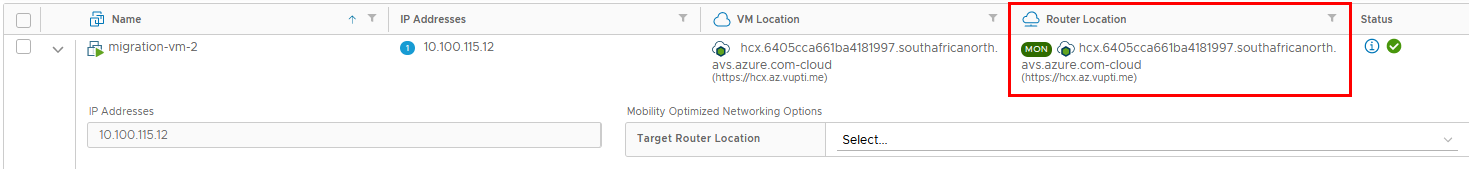

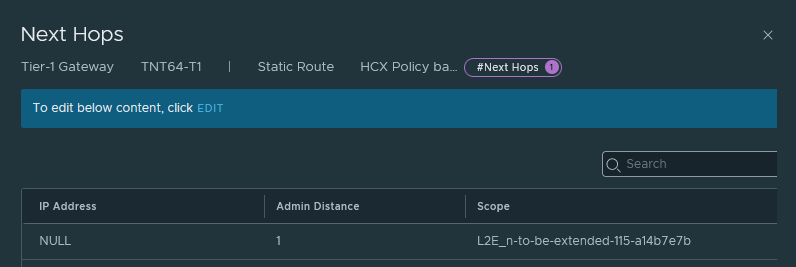

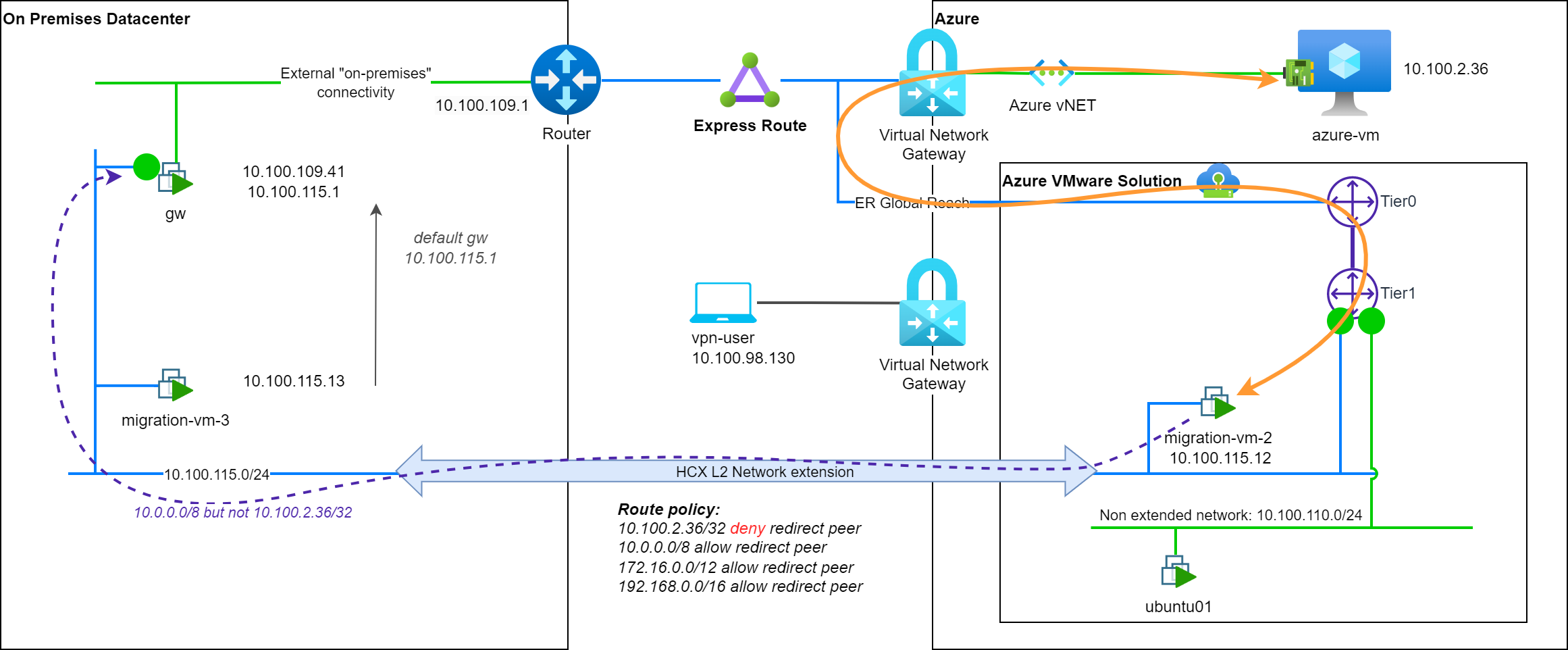

이 설계 토폴로지의 잘 알려진 한계 중 하나는 HCX와 MON( Mobility Optimized Network )의 동작 예측이 어렵다는 점입니다. 이것이 Microsoft가 타사 NVA 설정을 사용하는 AVS에서 Mobility Optimized Network를 지원하지 않는 이유입니다 .

'IT이야기 > Azure' 카테고리의 다른 글

| 허브 앤 스포크 토폴로지의 Azure VMware 솔루션 모형 – 2부 (0) | 2025.04.15 |

|---|---|

| 허브 앤 스포크 토폴로지의 Azure VMware 솔루션 모형 – 1부 (0) | 2025.04.15 |

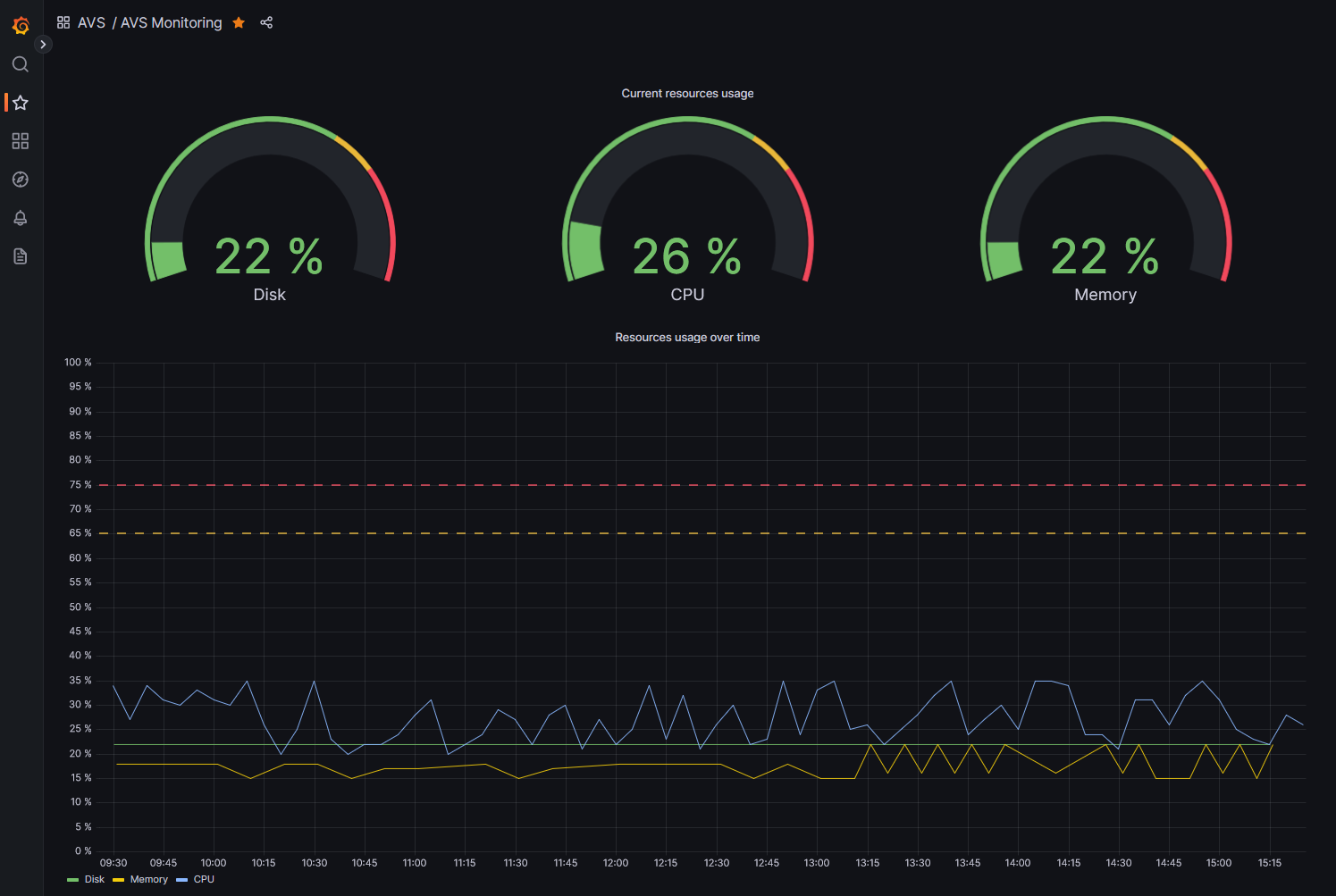

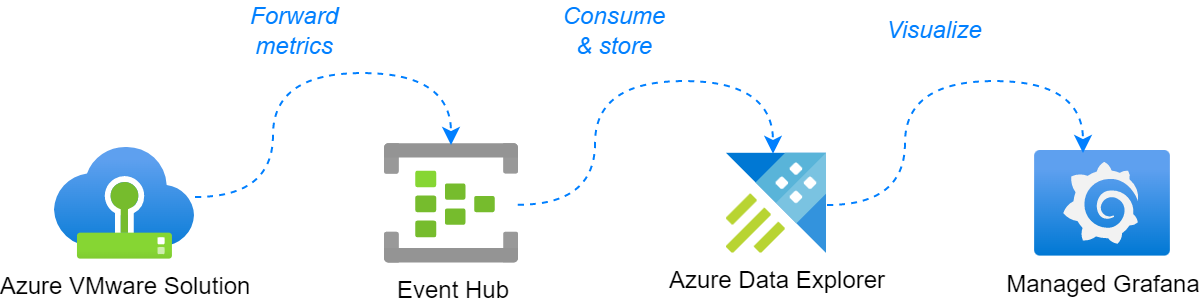

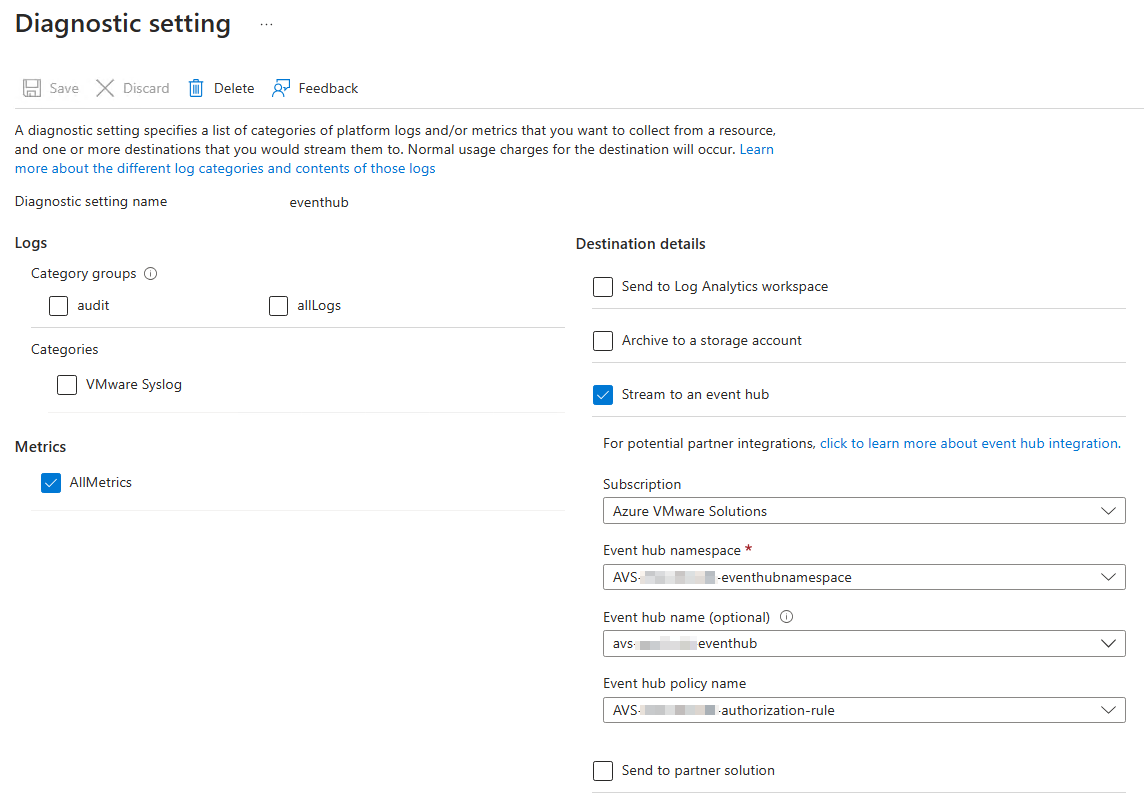

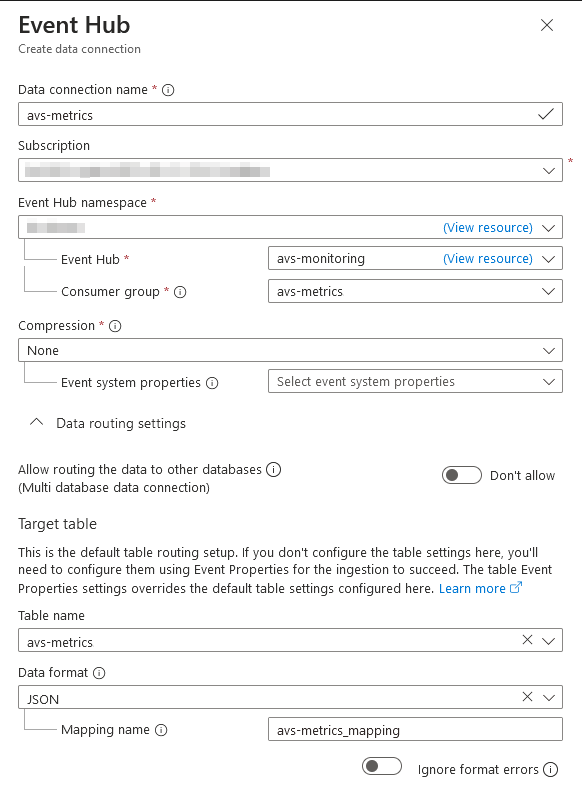

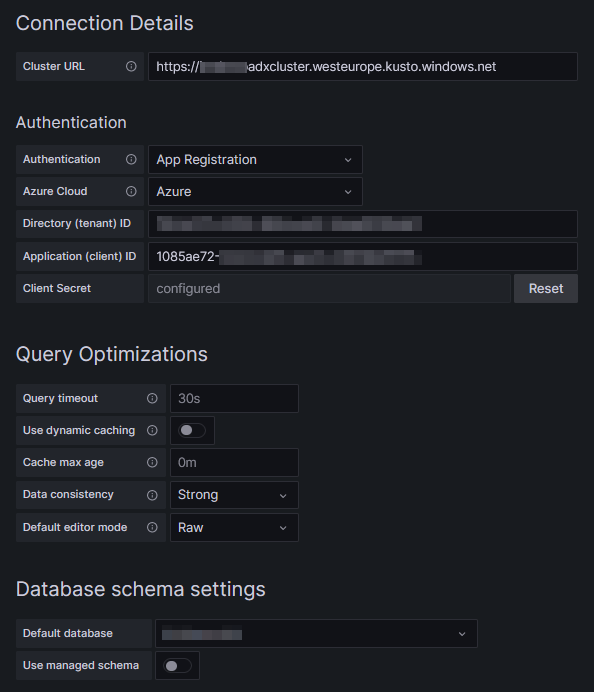

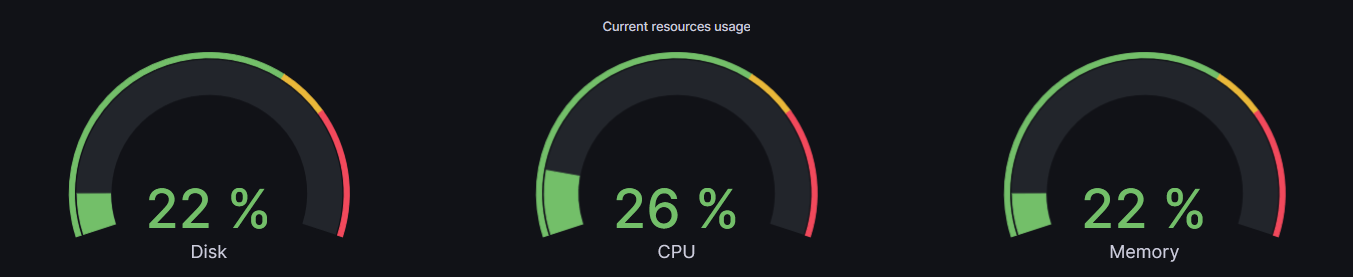

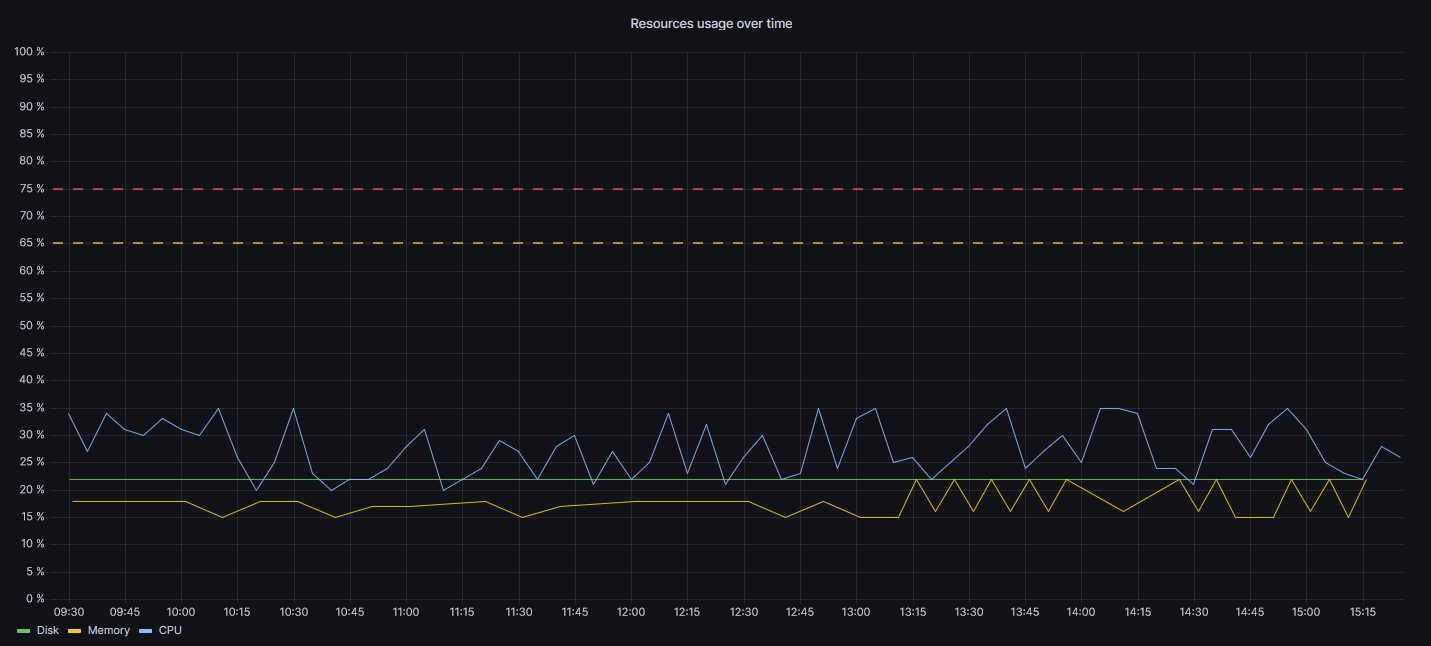

| Azure Data Explorer 및 Grafana를 사용하여 Azure VMware 솔루션 모니터링 (0) | 2025.04.15 |

| VMware HCX: MON으로의 복귀 (0) | 2025.04.15 |

| Azure VMware Solution 스토리지를 확장하기 위한 Azure Elastic SAN (0) | 2025.04.15 |